Découvrez notre coeur de métier et les grands enjeux de l’intelligence artificielle appliquée à l’acoustique !

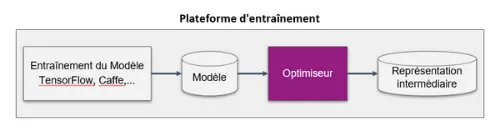

Découvrez notre coeur de métier et les grands enjeux de l’intelligence artificielle appliquée à l’acoustique ! Dans une logique de vulgarisation, nous partageons dans une série d’articles les thématiques qui font le quotidien de nos data scientists. Ce quatrième et dernier volet est consacré à la phase d’optimisation des modèles.

Lors de la création de modèle, la recherche d’optimisation est un élément essentiel pour qu’il soit le plus performant possible, à la fois en termes de résultats, mais surtout en termes de capacité de calcul, notamment lorsque celui-ci est déployé sur un système embarqué.

La taille et la latence du modèle sont en particulier deux paramètres clés.

Plusieurs solutions sont possibles :

- Quantification : il s’agit de réduire le nombre de bits pour représenter un nombre. Certains réseaux de neurones n’acceptent par exemple que du 8 bits ;

- Elagage des poids : lorsqu’un poids est proche de la valeur nulle, alors on lui attribue la valeur de 0 ;

- Fusion des couches (cela n’est pas nécessaire pour l’inférence)

- Package Python d’Intel : permet de réaliser ces compressions.

La validation des résultats avant et après compression est essentielle en utilisant les mêmes données d’entrée dans le modèle.

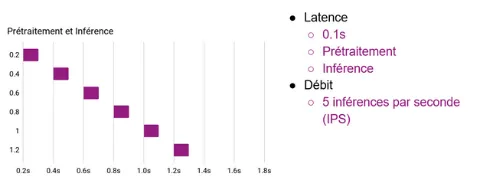

Latence et débit

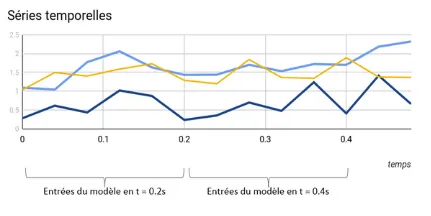

Sur cet exemple, nous allons réaliser une inférence sur les données temporelles toutes les 0,2s et mesurer le débit (nombre d’inférences réalisées par seconde).

Dans le premier cas, la latence est toujours égale à 0,1s, donc le système est validé car il fonctionne bien en temps réel et ne prend pas de retard par rapport aux 0,2s.

Dans le second cas, la latence est supérieure à 0,2s, le système prend alors de plus en plus de retard sur le traitement, et ne fonctionne pas en temps réel.

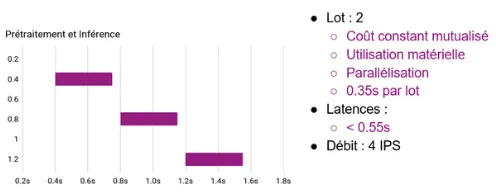

Inférence par lots

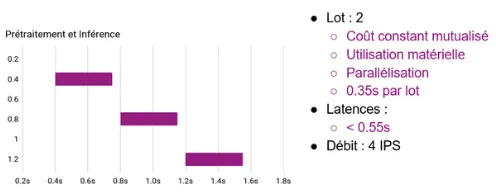

Une solution pour réduire la latence est de réaliser les inférences par lot, c’est à dire de les exécuter en parallèle.

Ici, au lieu de réaliser une inférence sur les données toutes les 0,2s, nous prenons les données de 2 périodes pour réaliser les inférences en parallèle.

Nous utilisons alors plus de ressources matérielles, et l’exécution est plus optimale car les coûts sont mutualisés.

Cependant, plus les lots sont conséquents, plus on utilisera de ressources matérielles. Il faut alors trouver le compromis entre les capacités du système matériel et la latence maximale acceptable.

Suivez notre série d’articles sur le déploiement des modèles au plus près des données !

⚙️Partie 1 : La différence entre inférence et entraînement

⚙️Partie 2 : Inférence en périphérie, inférence centralisée : avantages et difficultés

⚙️Partie 3 : La phase de déploiement des modèles

Wavely est une société spécialisée dans la reconnaissance des sons, elle est constituée d’experts en la matière. Si vous avez des questions, ou des besoins en terme de capteurs acoustique et vibratoire, contactez nous sans plus tarder nous serions ravis d’échanger avec vous :

📧 contact@wavely.fr ou par téléphone 📞 03.62.26.39.08